PaLM-E, lo nuevo de Google, un modelo de lenguaje multimodal para la robótica

El equipo de Investigación en Robótica de Google ha desarrollado un nuevo modelo de lenguaje y robótica, PaLM-E, que combina la capacidad de los grandes modelos de lenguaje con los datos de los sensores de los robots. PaLM-E es un modelo generalista, capaz de realizar tareas tanto de visión como de lenguaje, así como de controlar robots y aprender de manera eficiente.

Cómo funciona PaLM-E

PaLM-E funciona mediante la inyección de observaciones en un modelo de lenguaje pre-entrenado, convirtiendo los datos del sensor, como las imágenes, en una representación comparable a cómo se procesan las palabras del lenguaje natural. Los modelos de lenguaje dependen de un mecanismo para representar el texto matemáticamente de una manera que las redes neuronales puedan procesar. Esto se logra dividiendo el texto en «tokens» que codifican las palabras y asociándolos con vectores de alta dimensión. El modelo de lenguaje puede aplicar operaciones matemáticas sobre la secuencia resultante de vectores para predecir el siguiente token de palabra más probable. Al alimentar la palabra recién predicha en la entrada, el modelo de lenguaje puede generar iterativamente un texto más largo.

Los inputs de PaLM-E son textos y otras modalidades, como imágenes, estados de robots y representaciones de escenas, en un orden arbitrario, lo que llamamos «frases multimodales». La salida es texto generado auto-regresivamente por PaLM-E, que podría ser una respuesta a una pregunta o una secuencia de decisiones en forma de texto.

Un modelo encarnado y multimodal

PaLM-E se basa en el modelo de lenguaje PaLM y la arquitectura ViT-22B para la visión. La idea detrás de PaLM-E es entrenar encoders que conviertan una variedad de entradas en el mismo espacio que los «embeddings» de palabras naturales. Estas entradas continuas se transforman en algo que se parece a «palabras», aunque no necesariamente forman conjuntos discretos. Como los «embeddings» de palabras y de imágenes tienen la misma dimensionalidad, se pueden alimentar al modelo de lenguaje.

PaLM-E es un modelo generalista, diseñado para la robótica pero también capaz de realizar tareas de visión y lenguaje. PaLM-E puede describir imágenes, detectar objetos, clasificar escenas, citar poesía, resolver ecuaciones matemáticas y generar código. Combina la eficacia del aprendizaje basado en el lenguaje con la capacidad de controlar robots y aprender de manera eficiente.

Transferencia de conocimiento

PaLM-E ofrece una nueva forma de entrenar modelos generalistas, lo que se logra mediante la combinación de tareas de robótica y de visión y lenguaje a través de una representación común: tomar imágenes y texto como entrada y producir texto como salida. Un resultado clave es que PaLM-E logra una transferencia de conocimiento positiva tanto desde los dominios de visión como de lenguaje, mejorando la eficacia del aprendizaje del robot.

La transferencia de conocimiento positiva desde tareas de visión y lenguaje a la robótica permite que PaLM-E pueda abordar un gran conjunto de tareas de robótica, visión y lenguaje simultáneamente, sin degradación del rendimiento en comparación con el entrenamiento de modelos individuales en tareas individuales. Los datos de visión y lenguaje mejoran significativamente el rendimiento de las tareas de los robots. Esta transferencia permite que PaLM-E aprenda tareas de robótica de manera eficiente en términos del número de ejemplos necesarios para resolver una tarea.

Los resultados muestran que PaLM-E puede abordar un conjunto diverso de tareas robóticas y de visión y lenguaje de manera efectiva. Cuando se encarga a PaLM-E que tome decisiones sobre un robot, se combina con una política de lenguaje de bajo nivel para traducir el texto en acciones de robot de bajo nivel.

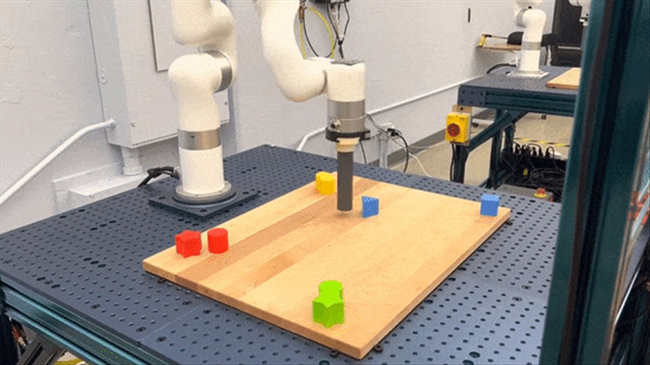

En un ejemplo, PaLM-E controla un robot móvil en una cocina para recoger una bolsa de patatas. En otro ejemplo, el robot es encargado de agarrar un bloque verde. Aunque el robot no ha visto ese bloque antes, PaLM-E genera un plan paso a paso que generaliza más allá de los datos de entrenamiento del robot.

En otro entorno, el modelo PaLM-E resuelve tareas de alto nivel y larga duración, como «ordenar los bloques por colores en esquinas», directamente desde las imágenes y produciendo una secuencia de acciones representadas textualmente. PaLM-E también demuestra la capacidad de generalizar a nuevas tareas no vistas durante el tiempo de entrenamiento, como empujar bloques rojos hacia una taza de café.

Sin duda PaLM-E representa un avance significativo en el campo de la robótica, combinando la capacidad de los modelos de lenguaje con la transferencia de conocimiento desde tareas de visión y lenguaje para abordar una amplia gama de tareas robóticas. Este enfoque multimodal y encarnado también tiene el potencial de unificar tareas que anteriormente parecían separadas. La capacidad de PaLM-E para realizar tareas de lenguaje, visión y robótica de manera eficiente, y generalizar a nuevas tareas no vistas, tiene implicaciones importantes para el futuro de la robótica y el aprendizaje multimodal.